Física Termodinâmica

Entropia

A variação de entalpia não é suficiente para prever a espontaneidade de um processo.

A entropia é uma medida do grau de desordem de um sistema

afirmando, ainda que a bagunça só tende a aumentar, como a charge abaixo retrata.

Embora divertida, esta associação entre entropia e o sentido de senso comum da palavra 'desordem' pode prejudicar a compreensão do conceito e ao uso incorreto da 2ª Lei da Termodinâmica. Uma relação correta cientificamente mais correta será vista abaixo.

Definição quantitativa de Entropia

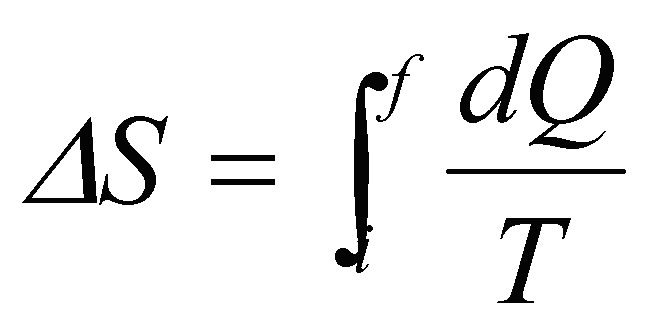

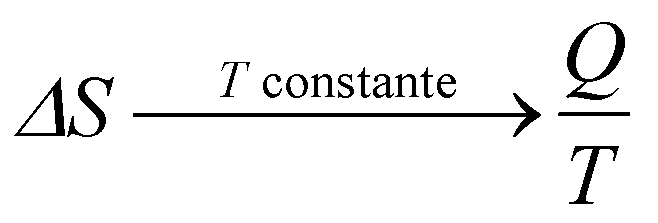

A variação de entropia de um processo reversível, em função do calor trocado, Q, e da temperatura, T, do sistema, é calculada como

No entanto, se o processo for isotérmico, isto é, ocorrer à temperatura constante, sua variação de entropia pode ser calculada por

Note que, sendo a temperatura, T, constante, o calor recebido ou dado, Q, vai ser utilizado para alterar a estrutura do sistema, não para aquecer ou resfriar o sistema.

Por exemplo, no caso do gelo derretendo-se esponteneamente, sabemos que a temperatura se mantém constante e igual à temperatura de fusão do gelo, a qual, em condições ideais, é de 0°C. Com isso, todo o calor fornecido pelo meio ambiente envolvente será utilizado para alterar as ligações entre as moléculas de água no gelo, de forma que elas passem do arranjo mais ordenado e rígido do gelo para a forma mais desordenada e fluída da água.

Observe, também, da equação acima para temperatura constante, que, se o sistema recebe calor, a entropia aumenta, enquanto que se ele fornece calor, sua entropia diminui.

A 2ª Lei da Termodinâmica

Talvez a entropia seja mais conhecida associada à 2ª Lei da Termodinâmica.

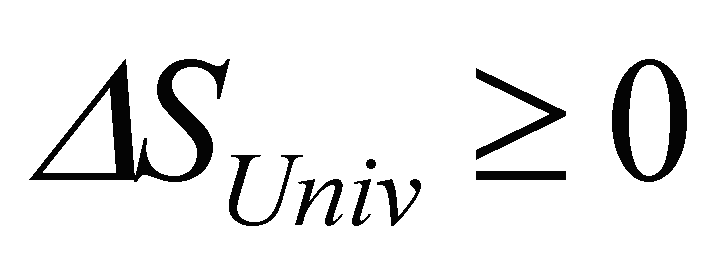

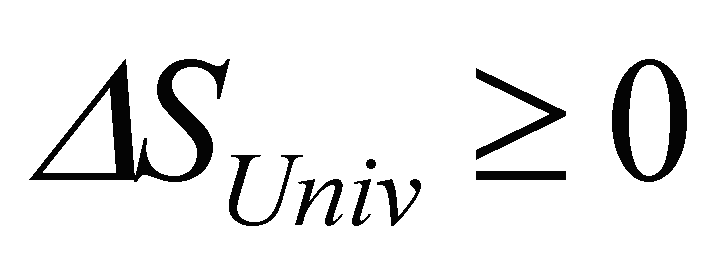

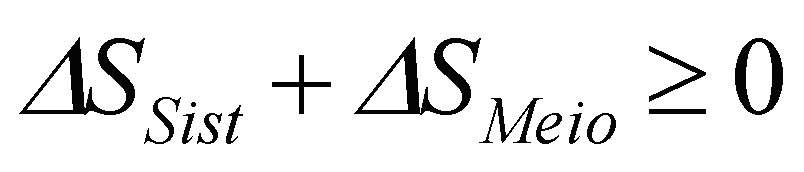

Um dos enunciados da 2ª Lei da Termodinâmica, em termos da entropia, a expressa como uma não-conservação: para sistemas fechados, a entropia não pode diminuir. Em termos quantitativos,

O sinal de igual aplica-se apenas a processos reversíveis, em equiíbrio.

Se um processo aumenta a entropia do sistema isolado, o processo inverso está vedado, pois levaria a uma diminuição da entropia, o que não é permitido, segundo essa lei. Consequentemente, um processo que aumente a entropia do sistema isolado é irreversível.

Irreversibilidade

Muitos fenômenos da Natureza são irreversíveis: uma pedra solta cai, não sobe; o café quente numa xícara esfria, não esquenta; etc. Os processos inversos só ocorreriam se energia externa fosse fornecida.

Por outro lado, há processos irreversíveis em que a energia se conservaria: uma extremidade de um garfo poderia se esfriar ao mesmo tempo em que a outra extremidade se esquentasse, as moléculas de ar numa sala poderiam se acumular todas num canto, etc.

Essa direção preferencial da Natureza, como vimos acima, corresponde à 2ª Lei da Termodinâmica.

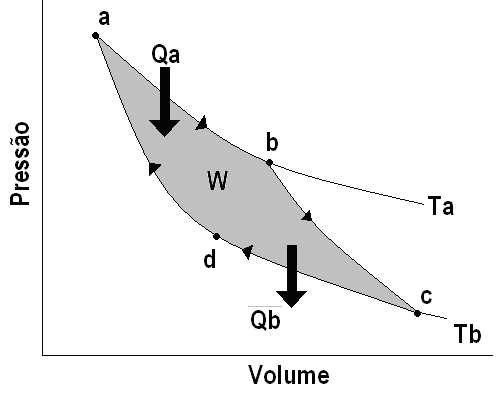

Irreversibilidade significa a impossibilidade de um sistema, após ter ido de um estado A para um estado B, retornar ao seu estado inicial A, com seu meio ambiente envoltente também retornado ao seu estado inicial. Geralmente é possível retornar o sistema ao seu estado inicial A, às custas de nova alteração no seu meio ambiente envolvente. Assim funcionam, por exemplo, as máquinas térmicas, tal como vimos na aula A Crise da Ciência no início do século XX.

Irreversibilidade significa a impossibilidade de um sistema, após ter ido de um estado A para um estado B, retornar ao seu estado inicial A, com seu meio ambiente envoltente também retornado ao seu estado inicial. Geralmente é possível retornar o sistema ao seu estado inicial A, às custas de nova alteração no seu meio ambiente envolvente. Assim funcionam, por exemplo, as máquinas térmicas, tal como vimos na aula A Crise da Ciência no início do século XX.

A irreversibilidade implica numa assimetria temporal do sistema, a existência de uma 'flecha do tempo'.

Visão estatística da Entropia

Um sistema termodinâmico é, necessariamente, um sistema com um enorme número de partes, até para poder ser tratado estatisticamente.

Todas as leis físicas são reversíveis em escala microscópica, para as partes individuais. Porém, uma mudança de estado em tal sistema, como um todo, significa uma mudança muito complicada no arranjo de todas essas partes, a qual inclui uma certa energia necessária para essa transformação, além de ocorrer alguma dissipação de energia em forma de calor, devido a colisões não perfeitamente elásticas e atrito entre as partes. Essa energia dissipada não pode ser recuperada e, portanto, não é possível trazer o sistema de volta à configuração inicial sem que o meio evolvente reponha essa energia.

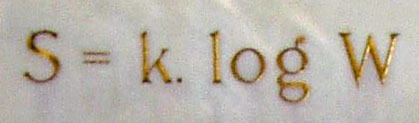

Desta forma, a irreversibilidade está associada à complexidade do sistema. Dito de outra forma, conforme Boltzmann demonstrou, em 1877, a entropia do sistema, S, cresce à medida que cresce o número de arranjos possíveis para os elementos do sistema, W, tal como está gravado em sua lápide

Desta forma, a irreversibilidade está associada à complexidade do sistema. Dito de outra forma, conforme Boltzmann demonstrou, em 1877, a entropia do sistema, S, cresce à medida que cresce o número de arranjos possíveis para os elementos do sistema, W, tal como está gravado em sua lápide

Quanto mais arranjos possíveis para os elementos do sistema, menor a probabilidade do sistema retornar espontaneamente ao estado inicial.

Desta forma, como há menos maneiras de ter o sistema 'ordenado' e muito mais maneiras de tê-lo desordenado, a entropia de um sistema num estado ordenado é menor do que a de um sistema desordenado. Esta é a ideia que está por trás do conceito de que Entropia é uma medida da 'bagunça' do sistema.

Além disso, o aumento da complexidade do sistema leva a uma maior sensibilidade do sistema às suas condições iniciais. Como vimos na aula A Revolução da Matemática, Poincaré demonstrou, em 1890, que pequenas perturbações no estado inicial, tais como um ligeira mudança na posição inicial do corpo, levariam a uma mudança radical em seu estado final, tornando impossível predizer a evolução e o estado final do sitema, antecipando a Teoria do Caos.

Além disso, o aumento da complexidade do sistema leva a uma maior sensibilidade do sistema às suas condições iniciais. Como vimos na aula A Revolução da Matemática, Poincaré demonstrou, em 1890, que pequenas perturbações no estado inicial, tais como um ligeira mudança na posição inicial do corpo, levariam a uma mudança radical em seu estado final, tornando impossível predizer a evolução e o estado final do sitema, antecipando a Teoria do Caos.Entropia de sistemas abertos (neugentropia)

Note que, num sistema aberto, a entropia pode diminuir,

desde que a entropia do meio envolvente aumente mais do que a do sistema diminuiu

desde que a entropia do meio envolvente aumente mais do que a do sistema diminuiu  e a soma das duas variações resulte positiva!

e a soma das duas variações resulte positiva!

Às vezes, para sistemas abertos, se designa a grandeza neguentropia, que é simplesmente o oposto de entropia, (-S). Esse conceito foi introduzido por Schrödinger, em seu livro What's life? (O que é a vida?), de 1943.

Por exemplo, imagine, nas figura abaixo, uma jazida de minério de ferro

e o próprio minério

Considere, conforme as figuras seguintes, que o minério é extraído e transformado em lingotes de aço

Naturalmente, sua entropia será diminuída no processo

Os lingotes podem ser usados para construir algo ainda mais complexo e organizado, com entropia muito menor, como a Torre Eiffel, por exemplo.

No entanto, para a extração, o depósito de minério terá que ser muito alterado e sua entropia muito aumentada

Seguramente, a variação total de entropia do minério mais seu meio ambiente será positiva, de acordo com a 2ª Lei da Termodinâmica.

Na verdade, é praticamente impossível que o Homem atue no seu meio ambiente sem causar um aumento irreversível de entropia. A 2ª Lei da Termodinâmica prevê isso!

Por outro lado, sistemas vivos evoluem para estruturas cada vez mais complexas. Consequentemente, a entropia dos seres vivos diminui!

Como pode ser isso?

Tal como no exemplo que vimos acima, como são sistemas abertos, trocando matéria e energia com o meio ambiente em que estão imersos, os seres vivos diminuem sua entropia à custa do aumento da entropia do meio ambiente!

Naturalmente, um ser vivo, quando morre, deixa de reduzir sua entropia; ao contrário, passa a se decompor, tal como os outros sistemas 'normais'.

Por outro lado, se for fechado, impedido de trocar matéria e energia com o seu meio ambiente envolvente, um ser vivo morre!

A compreensão dessa possibilidade de sistemas abertos reduzirem sua entropia à custa do meio envolvente valeu o Prêmio Nobel de Química de 1977 a Prigogine, conforme discutido na aula Complexidade e Transdisciplinaridade.

Entropia da Informação

O conceito de entropia pode ficar mais claro se o relacionarmos com o de entropia da informação.

Informação é um termo que vem sendo usado, a partir da década de 1950, por diferentes autores, significando mensagens, notícias, novidades, dados, conhecimento, literatura, símbolos, signos e, até mesmo, 'dicas' e sugestões.

A quantidade de informação de uma mensagem é calculada, na Teoria da Informação, como sendo o menor número de bits, unidade de informação introduzida por Shannon (vide abaixo), necessários para conter todos os valores ou significados desta mensagem. Assim, por exemplo, para codificar uma das 23 letras do nosso alfabeto, bastam 4 bits, pois eles podem armazenar 24=32 valores diferentes, enquanto que 8 bits (1 byte) conseguem armazenar os 256 caracteres (28) da codificação ISO 8859-1 de caracteres do alfabeto latino, com seus diacríticos.

Em 1948, o matemático norte-americano Shannon introduziu o conceito de entropia da informação, a qual quantifica o grau de incerteza de uma informação. Segundo ele, sempre que uma mensagem passa por um canal de comunicação, ela sofre perturbações e chega com ruídos ao receptor. Shannon enxergou aí uma analogia entre os processos onde há perda de informação e os processos que ganham entropia.

Segundo Wiener,

"a soma de informação em um sistema é a medida de seu grau de organização; a entropia é a medida de seu grau de desorganização; um é o negativo do outro".

Como um exemplo pitoresco, no processo abaixo, inicialmente, antes de se misturarem, teremos, no mínimo três informações:

- café quente;

- leite, eventualmente gelado;

- açúcar, à temperatura ambiente.

Após a mistura, teremos apenas uma informação: café-com-leite-adoçado-morno.

Com isso, o conceito de informação, isto é, de entropia negativa, pode ser aplicado para exprimir tanto a medida da ordem de um sistema nervoso quanto de um sistema social. Na verdade, a entropia de informação foi estendida às mais diversas áreas de conhecimento, tais como Ciência da Informação, Biologia, Medicina, Ecologia, Economia e Linguística, dentre outras.

Sistemas vivos

As ideias de irreversibilidade e complexidade tem um papel especial quando se referem a sistemas vivos.

Como vimos acima, os seres vivos conseguem diminuir sua entropia por serem sistemas abertos, eliminando-a no meio ambiente.

No entanto, pode-se pensar como o ser vivo, em sendo aberto, não se desestrutura, não perde sua informação constutiva.

Segundo os biólogos chilenos Humberto Maturana e Francisco Varela, um ser vivo é um sistema autopoiético, isto é, constitui-se numa rede fechada de processos, onde as moléculas produzidas geram a mesma rede de moléculas que as produziu, permitindo que ele, embora sempre mantendo interações com o meio, mantenha-se autônomo e constantemente se autorregulando e se autoproduzindo, no sentido de que seus elementos são produzidos a partir dessa mesma rede de interação circular e recursiva. Como vimos na aula Complexidade e Transdisciplinaridade, sistemas complexos podem manifestar uma auto-organização auto-referencial, 'emergindo' do sistema como um todo.

Segundo os biólogos chilenos Humberto Maturana e Francisco Varela, um ser vivo é um sistema autopoiético, isto é, constitui-se numa rede fechada de processos, onde as moléculas produzidas geram a mesma rede de moléculas que as produziu, permitindo que ele, embora sempre mantendo interações com o meio, mantenha-se autônomo e constantemente se autorregulando e se autoproduzindo, no sentido de que seus elementos são produzidos a partir dessa mesma rede de interação circular e recursiva. Como vimos na aula Complexidade e Transdisciplinaridade, sistemas complexos podem manifestar uma auto-organização auto-referencial, 'emergindo' do sistema como um todo. Humor

Existem várias versões humorísticas das Leis da Termodinâmica. Uma delas, atribuída ao escritor e cientista inglês Charles Percy Snow, é a seguinte:

- Você tem que entrar no jogo;

- Você não consegue ganhar;

- Você não consegue empatar;

- Você não consegue parar de jogar.

Veja aqui minha aula sobre A crise da Ciência no inicio do século XX.

Veja aqui minha aula sobre Complexidade e Transdisciplinaridade.

Voltar a Física Termodinâmica.

Citar esta página:

dos SANTOS, Renato P. Física Termodinâmica - Entropia. In Física Interessante. 17 Nov. 2014. Disponível em: <http://www.fisica-interessante.com/fisica-termodinamica-entropia.html>. Acesso em: 05 de set. 2018.

FONTE http://www.fisica-interessante.com/fisica-termodinamica-entropia.html